Diverses recherches en sciences sont relayées dans en direct. D’un article à l’autre, quel est leur trait d’union le plus évident ? La langue française ! Le n° 300 est l’occasion d’un petit état des lieux du français aujourd’hui, de l’écrit à l’oral, de la norme à la pratique. Une langue dont l’évolution, comme celle de la société, est fortement marquée par l’avènement du numérique.

L’Académie française, photo Patrick Kovarik

Recours trop systématique aux anglicismes et aux barbarismes, approximations orthographiques des sms, intérêt ou pas de l’écriture inclusive…, les polémiques médiatiques dont le français fait l’objet seraient typiquement… françaises ! Comme l’Académie, créée en 1635 par Richelieu, une sacro-sainte institution qui n’existe pas dans tous les pays.

« La France est très attachée à sa langue écrite, considérée comme un patrimoine notamment par les membres de l’Académie française et par la plupart des gens de lettres, les écrivains ou les journalistes. C’est le français des dictionnaires, celui qui correspond à la norme », explique Sandra Nossik, enseignante-chercheuse en sociolinguistique à l’université de Franche-Comté / ELLIADD.

La centralisation de longue date du territoire et l’héritage de la Révolution ont contribué à l’adoption d’une langue unique et accessible à tous, une tendance plus tard encouragée, là comme ailleurs, par les médias de masse. Sandra Nossik note cependant que par définition, une langue n’est pas uniforme, mais riche de pratiques langagières différentes. Le français n’échappe pas à la règle. La chercheuse s’amuse du caractère faussement alarmant de certaines discussions, rappelant par exemple que l’usage des abréviations ne date pas d’hier, les emprunts aux autres langues non plus. « Le recours à des mots issus de langues étrangères est aujourd’hui plus voyant, mais ces contributions ne sont pas plus nombreuses que par le passé et concernent des champs limités. »

L’ assimilation de mots anglais répond parfois à la nécessité de combler des manques en français, mais correspond plus encore à des processus d’identification : le prestige du néolibéralisme en entreprise, la référence à des courants musicaux dans le domaine artistique. Surtout, la spécialiste souligne que le lexique n’est qu’une composante superficielle de la langue ; bien plus représentatives, la syntaxe et la phonologie, par exemple, qui concernent respectivement les liens hiérarchiques entre les mots d’une phrase et le système des sons d’une langue, restent relativement stables au fil du temps.

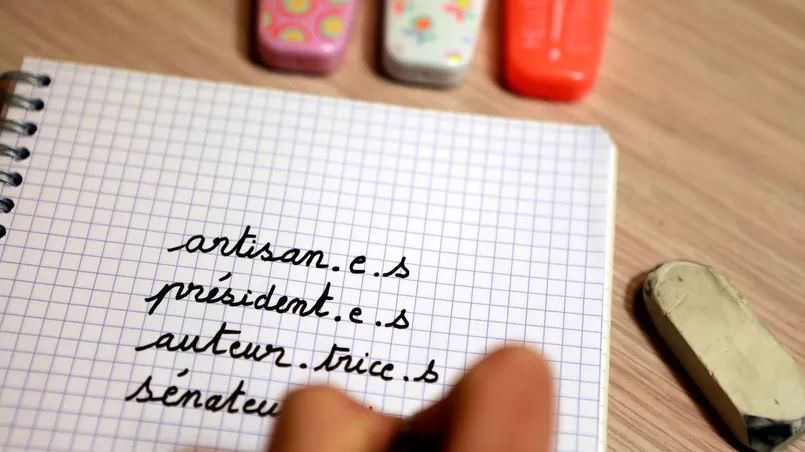

La féminisation des textes est un défi posé de longue date. Celle des noms de métier figure toujours, et depuis des années, à l’ordre du jour des réunions de l’Académie française. Hors du champ de l’institution, la question du genre dans les accords tient du casse-tête : si la règle du « masculin qui l’emporte » reste officielle, celle de la proximité, plus équitable et plus simple, fait à nouveau parler d’elle. D’usage en latin et en grec ancien, et toujours d’actualité en portugais ou en espagnol, cette loi grammaticale veut que l’accord de l’adjectif se fasse avec le nom le plus proche. Grande fut ma surprise et mon étonnement était d’ailleurs une construction encore en vigueur dans les grammaires françaises1 au début du XXe siècle.

Le féminin générique fait quelques apparitions, selon un principe inhabituel et annoncé d’emblée en début de texte, pour permettre à tout un chacun de s’y retrouver. C’est ainsi que les actrices fait aussi bien référence à la gent masculine et féminine sur le tournage d’un film. Plus largement répandue, prenant ses origines dans les milieux féministes, l’écriture inclusive est une proposition en vogue depuis une quinzaine d’années et suit diverses métamorphoses. Habitué de longue date des documents administratifs, le (e), comme usité dans je soussigné(e), est aujourd’hui décrié, les femmes ne voulant pas simplement être mises entre parenthèses. La majuscule E est ensuite employée, puis le tiret, puis le point médian, des évolutions spontanées qui ont du mal à se fixer.

L’absence de norme dérange et fait le jeu des détracteurs de l’écriture inclusive. « Certains arguments avancés, comme le manque d’esthétisme, ne sont pas recevables du point de vue de la linguistique », remarque Sandra Nossik. « Trop compliquée » apparaît presque drôle, compte tenu de la complexité de l’orthographe française. « Trop dangereuse » ne s’avoue pas toujours, mais souligne le fait que certains hommes peuvent se sentir menacés : ce sont à de telles implications sociales de l’évolution de la langue que s’attachent notamment les études en sociolinguistique.

Photo sauvageauch0 – Pixabay

Si le respect d’une certaine norme, qui a trait à la grammaire et à la syntaxe, est nécessaire à la compréhension d’une langue, celle-ci ne doit pas pour autant se figer dans une posture de musée. Une langue est par essence amenée à évoluer, à s’adapter à une société et à ses moyens de communication ; comme d’autres, le français du XXIe siècle est revisité par l’usage du numérique, qui participe d’une tendance naturelle à aller vers la simplification. Langue éminemment complexe, le français fourmille d’exemples pour lesquels la norme sociale pourrait prendre le pas sur la norme académique.

Le seul registre des verbes avec prépositions fournit des modèles du genre. Faut-il dire pallier ou pallier à ? Le second fait grincer les dents des puristes, mais il se comprend aussi bien que le premier ; et pour les linguistes comme Sandra Nossik, il ne va pas à l’encontre de la norme du français, car d’autres verbes sont construits de cette manière. Autre exemple de difficulté, la formule à deux composants ne… pas pour marquer la négation, dont l’usage devient plus délicat encore à la forme interrogative. « En italien comme dans d’autres langues, un seul mot suffit. Non voglio est tout de même plus simple à manipuler que je ne veux pas… »

Professeur certifié de lettres, Florent Montaclair enseigne de son côté la grammaire à l’INSPÉ (Institut national supérieur du professorat et de l’éducation) de Franche-Comté auprès des futurs professeurs des écoles, et mène des recherches dans cette discipline. Il insiste lui aussi sur le problème de la complexité de la langue, qui provient pour partie de la volonté d’en supprimer certaines ambiguïtés, grâce à l’orthographe. Ainsi on écrit de plusieurs manières les trois sons qui composent ver, pour lever le doute sur différentes interprétations possibles : verre, vert, ver ou encore vers. Pourtant le contexte suffit la plupart du temps à saisir le sens. Apporter un verre sur la table pour boire de l’eau se comprend quelle que soit la façon dont on écrit ce mot. « Et rappelons d’ailleurs que l’intérêt d’une langue est précisément son ambiguïté, qui permet des jeux de mots, la poésie, le style… »

Les règles de français résultent de décisions qui ont été prises à un moment donné par les Académiciens. Certaines fonctionnent, et d’autres moins. Ainsi dans l’adjectif vert, le t permet de construire facilement le féminin verte. « Mais quelle est la légitimité du d de l’adjectif verdâtre ? » Florent Montaclair rappelle que ces règles n’ont pas toujours existé, et que certaines sont même très récentes. Ainsi, Pagnol et Colette se moquaient de l’invention des participes passés, Chateaubriand, comme ses contemporains, ne mettait pas de t à la fin des participes présents, Molière écrivait des pièces de théâtre sans accents puisqu’ils n’existaient pas encore – autant d’ajouts faits par la suite pour les besoins de l’orthographe modernisée –, et Rabelais s’exprimait d’une façon telle qu’il faut aujourd’hui traduire ses romans pour les comprendre.

Certains axiomes sont discutables, du fait même de leurs origines. Les mots hibou ou chou de la célèbre litanie demandent un x au pluriel, parce qu’à une époque ancestrale, ils s’écrivaient avec un l à la fin. D’où une règle copiée sur des mots comme cheval / chevaux, alors que le l d’origine avait disparu de ces mots depuis belle lurette ! « Quelle aberration que de ne pas avoir choisi d’y mettre un s comme à clou ou à sou ! De telles règles, inutiles et sans fondement, demandent beaucoup de temps pour leur apprentissage. »

Dans un discours politique, Le défi galiléen, prononcé à l’Assemblée nationale en 2016, Florent Montaclair et le linguiste américain Noam Chomsky ont proposé une liste de dix modifications pour simplifier le français, sans qu’il soit question de toucher à la structure de la langue. Parmi elles, la suppression des redoublements de lettres comme les t ou les m, ce qui donnerait par exemple atendre au lieu d’attendre.

Une évolution qui bouscule la norme, mais qui peut séduire, une fois admis le côté bizarre de la nouveauté : « À l’école, le français et les mathématiques occupent toujours un gros volume d’enseignement, mais d’autres apprentissages se sont développés, amenant les élèves vers plus de compréhension du monde qui les entoure, et les incitant à plus de réflexion ; et à mesure que l’école progresse vers davantage de sens, la norme de l’écriture n’est plus comprise, l’orthographe historique perd sa légitimité ».

L’écrit pourrait ainsi faire beaucoup d’économies ; de nombreuses lettres ne servant à rien pourraient être supprimées, ce qui n’enlèverait rien au sens des mots et à la subtilité de la langue. Mais est-on prêt à adopter en France une nouvelle façon de considérer l’orthographe ? Ou l’orthografe ?, selon une écriture désormais admise par l’Académie, mais non appliquée. Le poids normatif de l’écrit pèse lourd. Tout comme la croyance dans une relation de cause à effet entre complexité d’apprentissage et construction de l’intelligence, que les travaux des neurosciences remettent pourtant en cause depuis vingt ans. Avec ses allures de révolution, la simplification n’est sans doute pas pour bientôt (anciennement bientost, peut-être un jour bientot, voire biento ?)

Photo letelegramme.fr

« Pourtant, il n’est pas utile d’ajouter de la complexité à un monde aussi anxiogène et complexe que celui d’aujourd’hui, saturé par une surabondance d’informations. » La simplification des règles n’entame pas la richesse d’une langue. En supprimant des barrières, elle permettrait au contraire aux individus d’y accéder plus facilement, et ainsi de les prémunir d’une certaine précarité sociale. « Une réforme rationnelle, encadrée, serait la meilleure solution pour éviter l’instauration d’une écriture bis, issue d’un mouvement naturel qui semble inéluctable », suggère Florent Montaclair.

Participant à cette évolution, la frontière entre l’écrit et l’oral n’est plus aussi nette que par le passé. « Les paroles s’envolent, les écrits restent », le dicton est mis à l’épreuve des pratiques numériques, qui balaient d’un doigt les mots de la mémoire des smartphones. Le caractère spontané et immédiat d’une communication a de tout temps été propre à l’oral, c’est désormais vrai aussi pour l’écrit. Et on n’a jamais autant écrit qu’aujourd’hui… Ce dernier constat est cependant à nuancer selon Pierre Jamet, enseignant-chercheur en histoire à l’université de Franche-Comté / ISTA : « Il s’agit surtout d’une écriture du quotidien ; les sms, mails ou dialogues en ligne s’apparentent à des discussions par téléphone. L’écriture numérique tient en réalité plus de l’oral que de l’écrit. »

Pierre Jamet note le recours aux signes linguistiques pour animer ce qu’il est d’usage d’appeler une conversation. Points d’exclamation ou de suspension appuient avec insistance le discours, une valeur d’expression renforcée par l’usage des émoticones, dont la large palette de sourires, clins d’œil et autres mimiques expressives aide le rédacteur à souligner les émotions qu’il veut transmettre. « On observe que le corps prend place dans l’écrit, ce qui est plutôt la caractéristique d’une langue parlée. » L’historien craint une sorte de retour en arrière, au temps d’avant l’écriture, non pas par mépris de la langue orale, mais parce que l’écriture témoigne d’une capacité d’abstraction qui donne de la puissance à ceux qui la maîtrisent.

Photo Morphart Creation – Shutterstock

« L’écriture est née pour des raisons commerciales, pour accroître la mémoire, faire des inventaires, gérer la propriété. Puis elle a subi une transformation qui l’a emportée vers l’abstraction, lui permettant de représenter des idées, et non plus seulement des objets. » Au Moyen Âge en Occident, les moines copistes inventent la ponctuation pour aider les novices à comprendre le sens des textes, à une époque où la lecture et l’écriture étaient encore l’apanage des élites.

Au milieu du XV e siècle, l’invention de Gutenberg allait changer la face du monde. Innovation technique crainte par les États, qui pour certains cherchèrent à l’interdire, l’imprimerie se développe, favorisant la diffusion des idées autant que la lecture individuelle, un grand pas vers l’émancipation de l’être humain. L’ adoption de la pratique silencieuse de la lecture renforce cette évolution : dispensé de la contrainte, en temps et en énergie, du déchiffrage à haute voix, le lecteur a dès lors la possibilité de s’approprier les textes et d’exercer sa pensée. « Les mots existèrent dans un espace intérieur, permettant des comparaisons avec la mémoire ou avec d’autres livres, accroissant les possibilités et la puissance de l’esprit. Cette mise au silence de la voix et cet élargissement simultané de l’esprit sont fondamentaux pour l’espèce humaine. »

Photo Everett Collection – Shutterstock

Faire régresser l’écrit vers l’oral représente pour Pierre Jamet une menace pour la pensée humaine, que renforce l’explosion des technologies de la communication. L’exemple de la reconnaissance vocale illustre cette crainte : il n’est plus nécessaire de savoir écrire, puisque la machine le fait pour nous… Mais n’est-ce pas là une porte ouverte vers l’illettrisme ? « Si on perd le sens des mots, si on ne sait pas par eux traduire des sensations, on n’a pas conscience de soi-même et on devient un robot. »

Comme d’autres spécialistes, Pierre Jamet redoute l’avènement d’une netocratie de l’information, gouvernée par ceux qui, tirant supériorité de leurs compétences dans le domaine des technologies, peuvent exercer leur pouvoir sur ceux qui n’en détiennent pas les codes. Les tris opérés dans les informations, la controverse des sources, la montée en puissance des fake news sont des symptômes de cette société à la George Orwell.

Photo sdx15 – Shutterstock

La technologie fournit donc des supports d’aide dont on peut craindre qu’ils se montrent nocifs, et pour le moins contreproductifs. Dans un registre particulier, les traducteurs automatiques se révèlent des outils en général très performants, mais leurs utilisateurs manquent parfois de la connaissance nécessaire pour bien les maîtriser. « Les traducteurs automatiques sont faciles d’accès, simples à utiliser et gratuits, mais cela ne veut pas dire qu’on s’en sert correctement », constate Sara Cotelli Kureth, chercheuse à l’Institut de langue et civilisation françaises et au Centre de langues de l’université de Neuchâtel, dans une étude interuniversitaire sur le sujet.

« Cette méconnaissance est renforcée par le fait qu’il ne vient à l’esprit de personne de parler de sa façon de faire : le côté pratique l’emporte, sans qu’on ressente le besoin de partager les expériences. » Une « pratique buissonnière », pour reprendre les mots de sa collègue française Aurélie Bourdais, adoptée aussi bien par les étudiants, les profs, les secrétaires ou les particuliers, et qui montre ses limites. Certaines anecdotes peuvent prêter à sourire, d’autres moins, engageant de sérieux impacts dans la communication académique, économique ou politique.

Ainsi, le mot « enceinte », entré seul dans un traducteur automatique, n’est pas reconnu comme un adjectif, ce qui donne « loudspeaker » en anglais, de quoi occasionner quelques non-sens. Politiquement incorrecte et plus embarrassante, la transformation par le traducteur de Facebook de Xi Jinping en « shithole », littéralement « trou du cul », lors d’une visite du président chinois au Myanmar en janvier 2020…

Selon Sara Cotelli Kureth, l’un des principaux écueils est de se servir des traducteurs automatiques comme de dictionnaires. Or il est nécessaire à ces outils d’avoir des informations de contexte pour associer un sens adéquat à un mot. « Les algorithmes produisent des calculs et des statistiques à partir de corpus de mots élaborés par l’être humain. La machine elle-même n’est pas en capacité de comprendre, une réalité qu’on a tendance à oublier. » Ainsi, le seul fait de ne pas mettre un point final à une phrase est susceptible de modifier une traduction.

Et sans indication de contexte, les systèmes sont à même de créer des mots de toutes pièces : l’utilisateur ne peut pas s’en rendre compte s’il n’a pas un minimum de connaissance de la langue concernée. D’où une deuxième recommandation : se servir des traducteurs pour la compréhension d’un texte, par transposition dans sa langue maternelle, plutôt que pour chercher à s’exprimer dans une langue qui nous est étrangère. On comprendra qu’il est également vain de leur confier la traduction d’expressions idiomatiques, dont on peut imaginer les casse-tête d’interprétation qu’elles représentent. Dans tous les cas, il faut éviter de placer une trop grande confiance en la machine, et prendre la peine de vérifier ses dires.

Pour aider les utilisateurs à comprendre la manière dont fonctionnent les traducteurs automatiques et à s’en servir de façon efficace et éclairée, le projet DigLit a été mis en œuvre entre quatre universités romandes, dont l’alma mater neuchâteloise, avec le soutien de Swissuniversities. Débuté en 2020 pour quatre ans, il fera à terme l’objet d’un site internet, d’ateliers de formation et de sensibilisation, et peut-être d’un MOOC.

Abeillé A., Godard D., La Grande Grammaire du français, Éditions Actes Sud, 2021

Habituellement, pour élaborer une grammaire, on part de l’écrit académique pour en tirer des conventions à respecter. La Grande Grammaire du français1 développe une autre conception au fil des 2 628 pages qui constituent ses deux volumes : son ambition est de recenser les usages du français, à l’écrit et à l’oral, depuis les années 1950 jusqu’à aujourd’hui, pour soumettre des propositions. Cet ouvrage gigantesque s’appuie sur des corpus de registres très divers, du texte littéraire à l’écrit journalistique, en passant par le parler régional.

« La méthode est plus descriptive que prescriptive, et veut qu’un regard scientifique soit porté sur les usages du français ; elle valorise ainsi la langue, d’une manière qui a suscité beaucoup d’enthousiasme de la part des médias lors de la parution de la Grammaire en octobre dernier », raconte Corinne Rossari, professeure en linguistique française à l’université de Neuchâtel, et l’une des 59 linguistes ayant participé à la rédaction de cet ouvrage hors du commun.

Des indications sont portées sur le niveau de langue d’un mot ou d’une forme grammaticale, sur les nuances qu’ils expriment ou encore sur leur rattachement à une région ; l’ouvrage donne à celui qui le consulte le choix d’utiliser une formulation en connaissance de cause, et en fonction de la façon dont il souhaite communiquer. « Il s’agit de savoir à quoi correspond ce que je dis. »

L’apport de Corinne Rossari à la Grammaire concerne les connecteurs, ces mots qui en relient d’autres à l’intérieur des phrases et qui combinent les phrases entre elles pour former les textes : des conjonctions comme car ou donc, des verbes tels que disons ou des groupes nominaux comme la raison ou la preuve. Les textes regorgent de ces petits mots qui donnent de la cohésion et du rythme à un texte. L’ un des enjeux est bien sûr leur portée interprétative : l’emploi, conscient ou non, de ces mots de liaison a priori bien innocents, peut apporter le jugement, le doute, la suggestion. Dans la simple phrase Marie a réussi son examen, mais c’était facile, le seul emploi de mais ôte tout mérite à Marie… On peut de là imaginer la valeur qu’ils peuvent prendre dans un discours politique par exemple, induisant une opinion sans qu’elle soit clairement explicitée. « Même dans un contenu purement informatif, dans une encyclopédie par exemple, on trouve des traces de partialité. C’est le fonctionnement même de la langue qui induit la subjectivité, l’information brute n’existe pas », souligne la spécialiste.

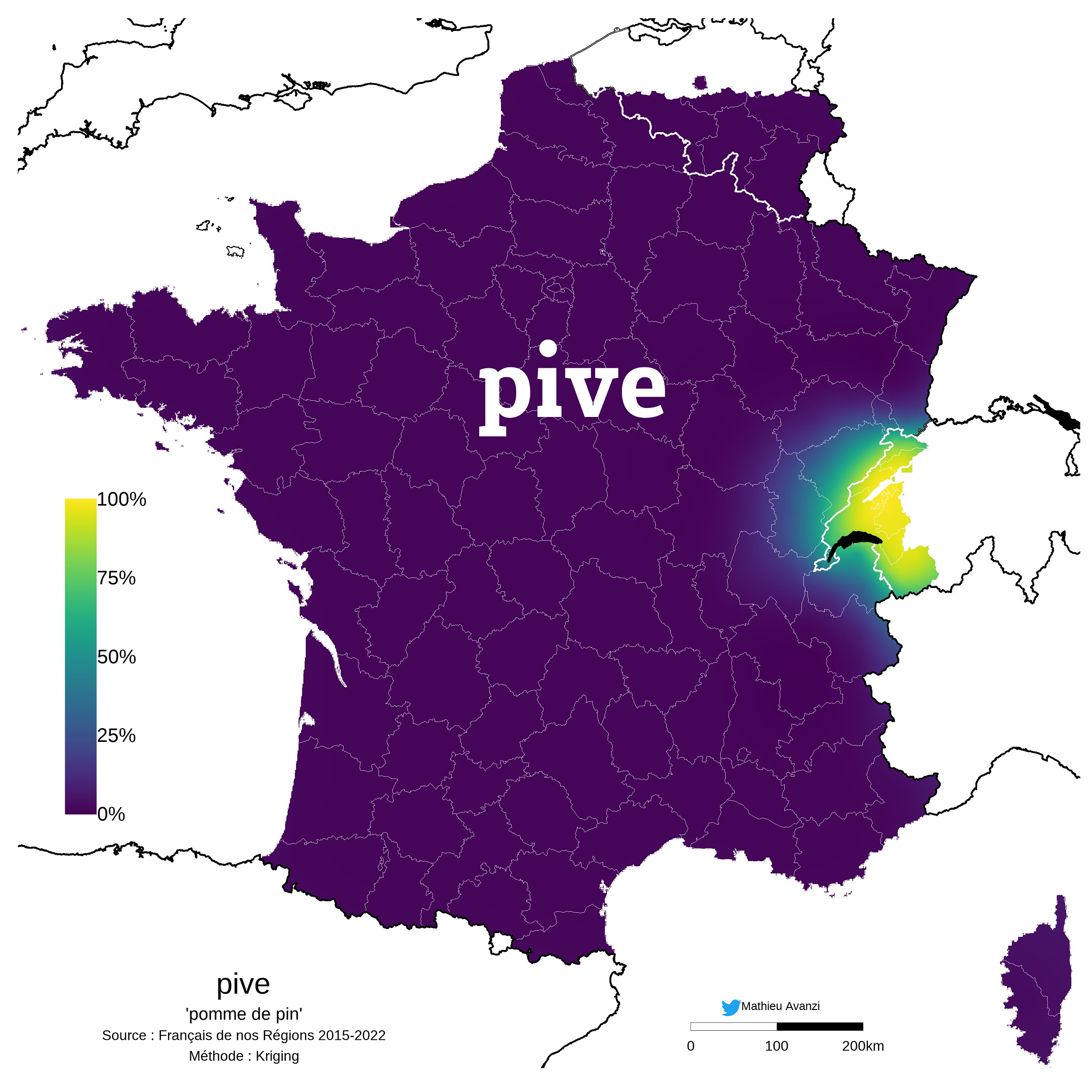

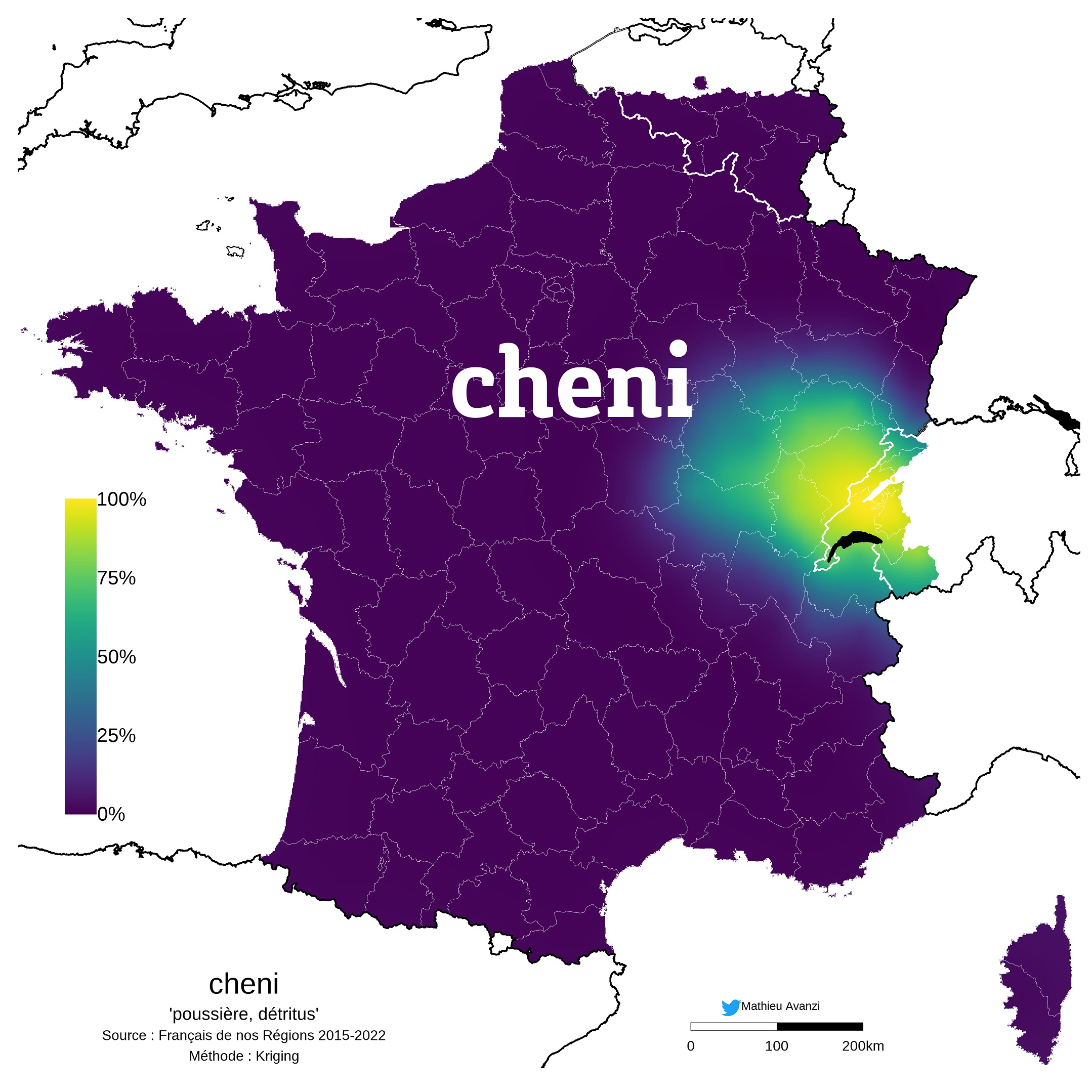

Mathieu Avanzi est professeur de dialectologie gallo-romane et sociolinguistique à l’université de Neuchâtel. Avec son équipe, il développe des applications sur smartphone pour recenser les usages du français à l’oral en France, en Suisse et en Belgique. « L’objectif est de documenter un état de la langue, de créer pour ces régions francophones un atlas sonore témoignant de la façon dont on parle le français au XXIe siècle. » Formes de grammaire, mots de vocabulaire, prononciation, expressions ont ainsi été soumis à différentes enquêtes depuis le lancement de l’étude en 2015, ayant depuis produit quelque 150 000 enregistrements et des résultats sous la forme d’une centaine de cartes et de trois ouvrages.

Mathieu Avanzi est professeur de dialectologie gallo-romane et sociolinguistique à l’université de Neuchâtel. Avec son équipe, il développe des applications sur smartphone pour recenser les usages du français à l’oral en France, en Suisse et en Belgique. « L’objectif est de documenter un état de la langue, de créer pour ces régions francophones un atlas sonore témoignant de la façon dont on parle le français au XXIe siècle. » Formes de grammaire, mots de vocabulaire, prononciation, expressions ont ainsi été soumis à différentes enquêtes depuis le lancement de l’étude en 2015, ayant depuis produit quelque 150 000 enregistrements et des résultats sous la forme d’une centaine de cartes et de trois ouvrages.

De consonance populaire ou vieillie, certains mots ont quitté le langage ou sont en voie de disparition, quand d’autres ont vu leur blason redoré grâce à leur « régionalisme plaisant ». Pive, qui désigne le fruit des conifères, s’est ainsi étendu du Jura à toute la Suisse romande, et a été adopté en 2017 en Franche-Comté pour désigner une monnaie locale. D’autres encore quittent leur région pour intégrer le français standard, à la faveur de coups de pouce médiatiques, comme le biloute du film Bienvenue chez les Ch’tis, à l’origine employé pour interpeller un ami dans le Nord de la France, ou les carabistouilles belges, remises à l’honneur par le président Macron en 2018, puis par les dictionnaires.

« On est parfois surpris de constater que certains termes ou expressions sont régionaux, parce qu’on est tellement habitués à les entendre et à les utiliser qu’on pense qu’ils font partie d’un lexique général », remarque Mathieu Avanzi. Ainsi c’est quelle heure ? ou sécher l’école sont bien d’ici. Tous ceux qui prononcent le t de vingt sont épinglés sur une carte, qui montre que cette prononciation n’est pas anecdotique mais qu’elle a cours dans l’Est et le Nord de la France, ainsi qu’en Suisse et en Belgique.

« On est parfois surpris de constater que certains termes ou expressions sont régionaux, parce qu’on est tellement habitués à les entendre et à les utiliser qu’on pense qu’ils font partie d’un lexique général », remarque Mathieu Avanzi. Ainsi c’est quelle heure ? ou sécher l’école sont bien d’ici. Tous ceux qui prononcent le t de vingt sont épinglés sur une carte, qui montre que cette prononciation n’est pas anecdotique mais qu’elle a cours dans l’Est et le Nord de la France, ainsi qu’en Suisse et en Belgique.

Grâce au machine learning, une nouvelle application nourrie d’informations récoltées sur le terrain depuis sept ans va prochainement voir le jour. Elle sera entre autres capable de déduire l’origine géographique d’un utilisateur, à la façon dont il prononce certains mots. Dis-lui comment tu parles, la machine dira d’où tu viens…

Pour en savoir plus : https://francaisdenosregions.com

Une étude en linguistique vient d’être lancée pour mieux cerner les préoccupations des habitants de l’Arc jurassien et la façon dont est véhiculée l’information sur ces sujets, de part et d’autre de la frontière franco-suisse. Transport, emploi, économie, logement, consommation…, les références à des problématiques communes seront mesurées par des outils textométriques et statistiques développés en linguistique, à partir de corpus de textes issus des discours de presse et de communications institutionnelles.

Cette étude résulte d’une collaboration inédite entre des équipes de linguistes en France et en Suisse ; elle est menée conjointement par Margareta Kastberg, professeure responsable du pôle Discours, texte, espace public et société (DTEPS) au laboratoire ELLIADD de l’université de Franche-Comté, et Corinne Rossari, professeure à l’Institut des sciences du langage (ISLa) à l’université de Neuchâtel. « La numérisation et le codage du corpus permettront de dégager les particularités syntaxiques, lexicales et thématiques des textes, et de les mesurer de façon systématique. L’analyse outillée des données servira leur interprétation », explique Margareta Kastberg.

Programmée jusqu’à la fin de l’année 2022, l’étude « Écrire en zone frontalière – Pratique et méthodes de l’écrit transfrontalier, approche linguistique des discours de presse et des discours institutionnels » est financée par la Communauté du savoir.

Vous vous êtes bien abonné·e à notre newsletter !

la reproduction de tout ou partie de ce site est formellement interdite sauf autorisation expresse du directeur de la publication.